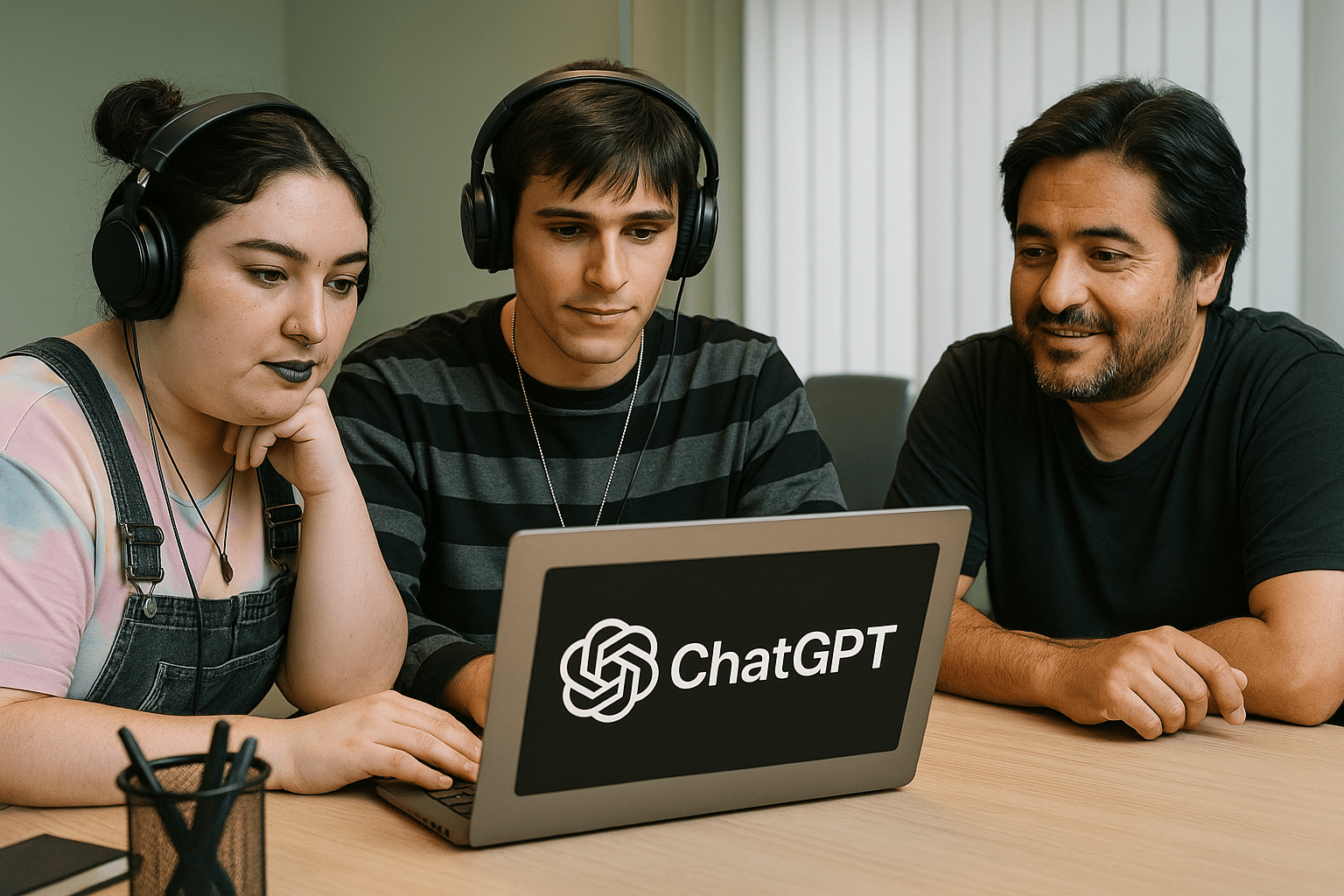

La inteligencia artificial se metió de lleno en las oficinas: el 74% de los trabajadores ya utiliza herramientas como ChatGPT, Gemini o Copilot para resolver tareas laborales. Sin embargo, solo un tercio recibió capacitación formal, según una encuesta global de la consultora Clutch. El dato, lejos de ser anecdótico, expone un problema estructural que puede traer errores, sesgos y hasta consecuencias legales para las empresas.

📈 El estudio revela que la mayoría de quienes usan IA lo hacen a diario (43%) o al menos una vez por semana (58%). Entre los rubros que más la adoptaron aparecen tecnología de la información (97%), diseño y creatividad (93%) y marketing (91%). Allí, los chatbots ya son parte de la rutina: redactan correos, generan ideas, ordenan cronogramas y hasta simulan entrevistas.

🧠 “La IA pasó de ser promesa a ser estructura”, explican desde Clutch. El crecimiento fue explosivo desde el lanzamiento de ChatGPT en 2023 y hoy su uso es tan común que incluso los departamentos de Recursos Humanos ya la utilizan para revisar currículums o redactar kits de bienvenida.

📌 Pero detrás de esa eficiencia, hay riesgos. El 45% de los trabajadores desconoce si en su empresa hay políticas internas sobre el uso de IA, lo cual abre la puerta a la exposición de datos sensibles, errores de criterio y decisiones tomadas en base a información incompleta o directamente falsa.

⚠️ El 76% de los empleados confía ciegamente en lo que responde la IA, aunque modelos como ChatGPT-4o tienen un margen de error de más del 11%. La dependencia sin supervisión puede provocar problemas serios en tareas clave como la atención al cliente, el análisis de datos o la elaboración de informes.

🧑💼 Además, el acceso a la formación es desigual: los altos cargos tienen casi el doble de posibilidades de capacitarse formalmente que los empleados más jóvenes o con menor jerarquía. Esto puede generar una falsa sensación de dominio tecnológico en los equipos, cuando en realidad falta comprensión profunda.

🧨 Casos recientes demuestran que la IA no es neutral. Experimentos como el de Bloomberg, que mostró cómo un generador de imágenes asociaba cargos de poder a hombres blancos y criminalidad a personas racializadas, refuerzan la preocupación sobre los sesgos. Si no se aborda con responsabilidad, el uso acrítico de IA puede traer consecuencias legales y reputacionales.

🗣️ Akash Shakya, ejecutivo de EB Pearls, fue tajante: “Confiar ciegamente en la IA puede ser un error. Puede hacerte perder clientes, credibilidad y dinero.”

💡 ¿Sabías esto? En 2024, una empresa canadiense fue multada con 2 millones de dólares tras despedir a un empleado basándose exclusivamente en una evaluación generada por IA que contenía sesgos de género. El caso se convirtió en el primero en su tipo y abrió el debate legal sobre la “responsabilidad compartida” entre humanos y máquinas.